Giới Thiệu: AI Mạnh Mẽ Ngay Trên Máy Tính Cá Nhân Của Bạn – Bước Tiến Mới Từ DeepSeek

Sự bùng nổ của các mô hình ngôn ngữ lớn (LLM) đang thay đổi cách chúng ta tương tác với công nghệ, và xu hướng “mang AI về nhà” ngày càng trở nên rõ rệt. Các mô hình trí tuệ nhân tạo, vốn được huấn luyện trên lượng dữ liệu văn bản khổng lồ để tạo ra các phản hồi giống như con người, đang ngày càng đa dạng và mạnh mẽ.1 Giờ đây, cộng đồng AI lại có thêm một tin vui: DeepSeek AI vừa trình làng DeepSeek R1 0528 Qwen 8B, một mô hình AI ấn tượng với 8 tỷ tham số, mở ra cơ hội cho nhiều người dùng trải nghiệm sức mạnh AI đỉnh cao ngay trên chính chiếc máy tính cá nhân của mình.2

Việc chạy các LLM cục bộ mang lại những lợi ích không thể phủ nhận. Trước hết, đó là yếu tố miễn phí. Người dùng không còn phải lo lắng về các chi phí API đắt đỏ thường thấy ở các dịch vụ đám mây.1 Quan trọng hơn, tính riêng tư và bảo mật được đảm bảo tối đa khi toàn bộ dữ liệu của bạn được xử lý trực tiếp trên máy tính, không hề bị gửi đi bất cứ đâu.5 Thêm vào đó, khả năng hoạt động offline cho phép bạn sử dụng AI mọi lúc mọi nơi, ngay cả khi không có kết nối internet (sau khi đã tải mô hình về máy).6 Cuối cùng, người dùng có toàn quyền kiểm soát, tự do tùy chỉnh và thử nghiệm không giới hạn.

Để biến việc trải nghiệm LLM cục bộ trở nên dễ dàng hơn bao giờ hết, LM Studio xuất hiện như một “cánh cửa thần kỳ”. Đây là công cụ được thiết kế để đơn giản hóa tối đa quá trình cài đặt và sử dụng các LLM ngay trên máy tính cá nhân, kể cả với những người không chuyên sâu về kỹ thuật.5

Sự ra đời của các mô hình nguồn mở mạnh mẽ như DeepSeek R1 0528 Qwen 8B, kết hợp với các công cụ thân thiện như LM Studio, đang thực sự dân chủ hóa AI và trao quyền cho người dùng cá nhân. Việc DeepSeek R1 0528 Qwen 8B là một mô hình nguồn mở 2 và có thể chạy cục bộ miễn phí qua LM Studio 8 đã hạ thấp đáng kể rào cản tiếp cận công nghệ AI tiên tiến. Điều này không chỉ đơn thuần là tiết kiệm chi phí; nó còn mở ra không gian cho các nhà phát triển độc lập, nhà nghiên cứu và cả những người đam mê công nghệ tự do đổi mới, học hỏi và xây dựng các giải pháp AI tùy chỉnh theo nhu cầu riêng, mà không phải phụ thuộc vào các nhà cung cấp bên ngoài hay lo ngại về vấn đề riêng tư. Sự phổ biến của các LLM cục bộ mạnh mẽ có thể thúc đẩy hiểu biết về AI trong cộng đồng, tạo ra những ứng dụng mới mẻ trong các lĩnh vực chuyên biệt và có khả năng làm giảm sự phụ thuộc vào một số ít các nhà cung cấp AI lớn.

Hơn nữa, sự cộng hưởng giữa mô hình mở và công cụ tiện lợi đóng vai trò then chốt. DeepSeek liên tục phát hành các mô hình nguồn mở mạnh mẽ 2, trong khi các công cụ như LM Studio 8 và Ollama 9 giúp việc vận hành chúng trở nên đơn giản hơn. Giá trị của một mô hình nguồn mở được khuếch đại đáng kể nhờ những công cụ dễ sử dụng này; nếu không có chúng, nhiều người dùng sẽ không thể khai thác hết tiềm năng của các mô hình. Mối quan hệ cộng sinh này tạo ra một vòng lặp phản hồi tích cực: việc phát hành mô hình nguồn mở tạo ra nhu cầu về các công cụ triển khai thân thiện, và ngược lại, sự sẵn có của các công cụ này khuyến khích nhiều người hơn thử nghiệm và đóng góp vào phong trào AI nguồn mở. Đây là một hệ sinh thái hợp tác, nơi các nhà phát triển mô hình và người tạo công cụ gián tiếp hỗ trợ lẫn nhau, mang lại lợi ích cuối cùng cho người dùng.

Tìm Hiểu Về DeepSeek R1 0528 Qwen 8B – “Bộ Não” AI Mới Cho Laptop Của Bạn

DeepSeek R1 0528 Qwen 8B là gì?

Đây là một phiên bản nâng cấp đáng chú ý trong dòng DeepSeek-R1, một họ các mô hình suy luận mở (open reasoning model) được cộng đồng đánh giá cao.2 Điểm đặc biệt của mô hình này là nó được “chưng cất” (distilled) từ một mô hình DeepSeek-R1 lớn hơn, sau đó được tinh chỉnh (fine-tuned) dựa trên nền tảng Qwen3 8B (cụ thể là từ dòng Qwen-2.5 series) với dữ liệu suy luận do chính DeepSeek-R1 tạo ra.2 Với 8.19 tỷ tham số 2, DeepSeek R1 0528 Qwen 8B là một mô hình mã nguồn mở hoàn toàn, được phát hành dưới giấy phép MIT, cho phép người dùng tự do sử dụng cho mục đích thương mại và tạo ra các sản phẩm phái sinh.2

Những cải tiến và khả năng vượt trội:

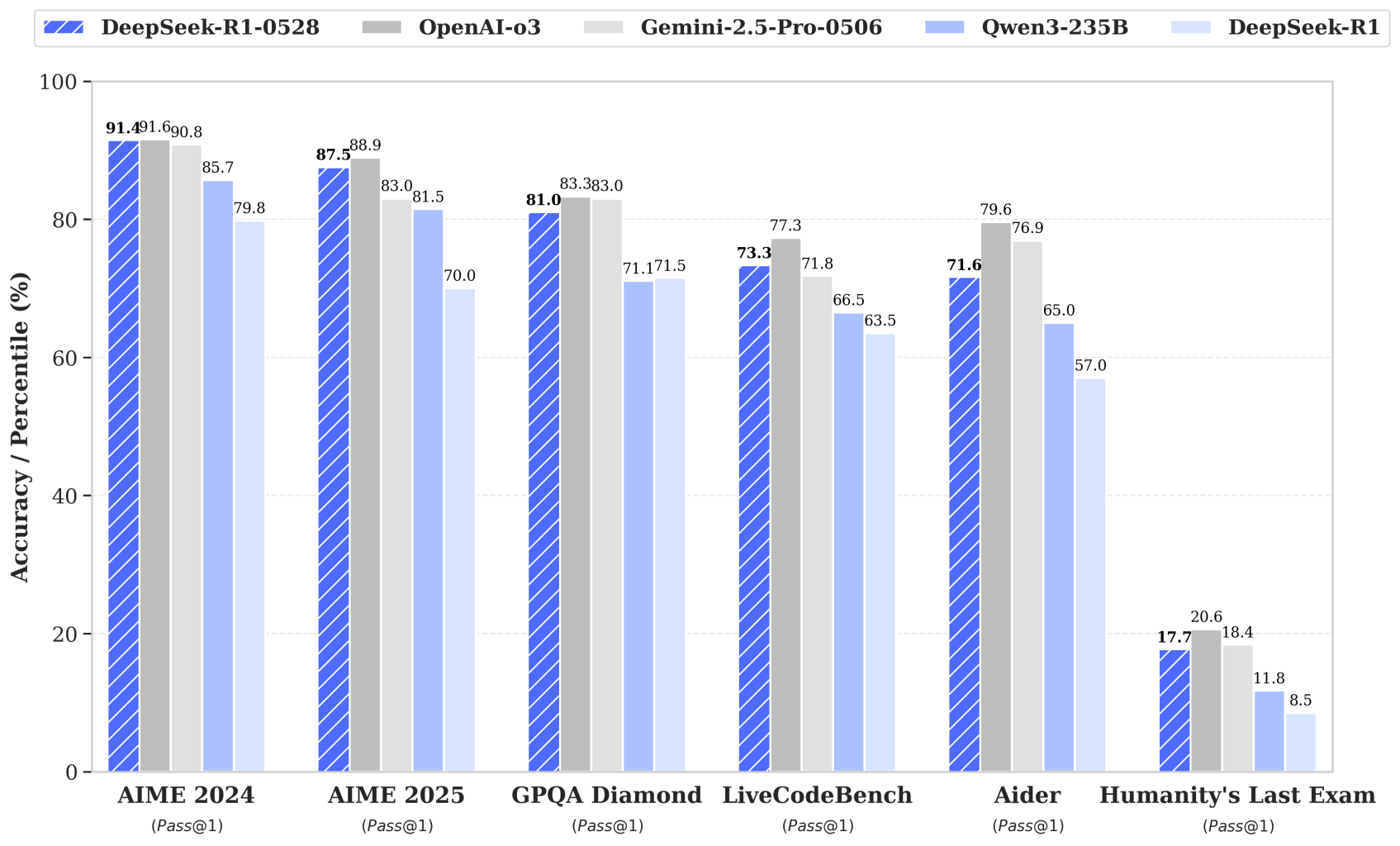

Phiên bản DeepSeek R1 0528 Qwen 8B mang đến những cải tiến đáng kể về khả năng suy luận sâu và logic.2 Mô hình này đã chứng minh hiệu suất ấn tượng trong nhiều bài kiểm tra benchmark uy tín về các lĩnh vực như toán học, lập trình và logic tổng quát, với kết quả tiệm cận các mô hình hàng đầu thị trường như O3 của OpenAI và Gemini 2.5 Pro của Google.2 Một điểm đáng kinh ngạc là phiên bản chưng cất DeepSeek-R1-0528-Qwen3-8B này có thể vượt trội hơn cả những mô hình lớn hơn với hàng chục tỷ tham số trong một số tác vụ cụ thể, ví dụ như việc đánh bại Qwen3 8B tiêu chuẩn tới +10 điểm phần trăm và ngang bằng với “gã khổng lồ tư duy” 235 tỷ tham số trên AIME 2024.12 Ngoài ra, mô hình còn giảm thiểu tỷ lệ “ảo giác” (hallucination) – tức là đưa ra thông tin sai lệch – và cải thiện khả năng gọi hàm (function calling).4

“Qwen” trong tên model có ý nghĩa gì?

“Qwen” (hay Thông Nghĩa Thiên Vấn – 通义千问) là tên gọi của một họ các mô hình ngôn ngữ lớn được phát triển bởi Alibaba Cloud.15 DeepSeek đã tận dụng nền tảng Qwen (cụ thể là Qwen-2.5 series 2) để tinh chỉnh và tạo ra phiên bản DeepSeek R1 0528 Qwen3 8B, qua đó kết hợp sức mạnh và ưu điểm của cả hai dòng mô hình. Dòng Qwen của Alibaba Cloud bao gồm nhiều phiên bản chuyên biệt như Qwen-VL (xử lý hình ảnh), Qwen-Audio (xử lý âm thanh), Qwen-Coder (lập trình) và Qwen-Math (toán học), cho thấy sự đa dạng và năng lực của nền tảng này.17 Việc hiểu rõ nguồn gốc này giúp người dùng hình dung rõ hơn về nền tảng công nghệ của DeepSeek R1 0528 Qwen 8B.

Một trong những yếu tố làm nên sức mạnh của DeepSeek R1 0528 Qwen 8B chính là kỹ thuật “chưng cất” (Distillation) trong LLM. Mô hình này là một “distilled model” 2, và DeepSeek tin rằng các mẫu suy luận từ những mô hình lớn hơn có thể được “chưng cất” một cách hiệu quả vào các mô hình nhỏ hơn, mang lại hiệu suất tốt hơn so với việc huấn luyện học tăng cường (RL) trực tiếp trên các mô hình nhỏ.2 Kỹ thuật chưng cất cho phép tạo ra các mô hình nhỏ gọn, hiệu quả hơn mà vẫn giữ được phần lớn sức mạnh của các mô hình lớn, phức tạp. Việc áp dụng distillation đã tạo ra một mô hình 8B mạnh mẽ, có khả năng đánh bại Qwen3 8B tiêu chuẩn và thậm chí cạnh tranh với các mô hình hàng trăm tỷ tham số trong một số bài kiểm tra.12 Điều này làm cho mô hình trở nên đặc biệt phù hợp để chạy cục bộ trên các phần cứng có tài nguyên hạn chế. Chưng cất không chỉ đơn thuần là thu nhỏ mô hình, mà còn là một phương pháp “truyền tải tri thức” hiệu quả từ các “gã khổng lồ” AI sang các mô hình “nhẹ ký” hơn. Điều này đặc biệt quan trọng trong bối cảnh ngày càng có nhiều nhu cầu triển khai AI trên các thiết bị biên hoặc cho người dùng cá nhân. Nó cho thấy một hướng đi để tối ưu hóa hiệu suất mà không nhất thiết phải liên tục tăng kích thước mô hình, hứa hẹn sự ra đời của nhiều mô hình chuyên biệt, hiệu quả cao cho các tác vụ cụ thể.

Bên cạnh đó, tầm quan trọng của giấy phép MIT và tính mở cũng là một yếu tố đáng chú ý. Toàn bộ dòng DeepSeek-R1, bao gồm cả phiên bản Qwen3 8B, được cấp phép theo giấy phép MIT.2 Giấy phép này không chỉ hỗ trợ việc sử dụng cho mục đích thương mại mà còn cho phép mọi sửa đổi và tạo ra các công việc phái sinh. Giấy phép MIT là một trong những giấy phép nguồn mở thông thoáng nhất, khuyến khích sự đổi mới và ứng dụng rộng rãi. Việc DeepSeek lựa chọn giấy phép MIT cho một mô hình mạnh mẽ như R1 0528 Qwen 8B là một tuyên bố mạnh mẽ về cam kết của họ với cộng đồng nguồn mở. Điều này không chỉ cung cấp công nghệ mà còn cả sự tự do để sử dụng và phát triển công nghệ đó, tạo điều kiện thuận lợi cho các nhà phát triển và doanh nghiệp thử nghiệm, tích hợp và xây dựng các sản phẩm thương mại. Sự lựa chọn này có thể thu hút một lượng lớn người dùng, tạo ra một cộng đồng sôi động xung quanh DeepSeek R1 và thúc đẩy sự phát triển của hệ sinh thái AI mở.

LM Studio: “Sân Chơi” LLM Cục Bộ Cho Mọi Người

LM Studio là gì?

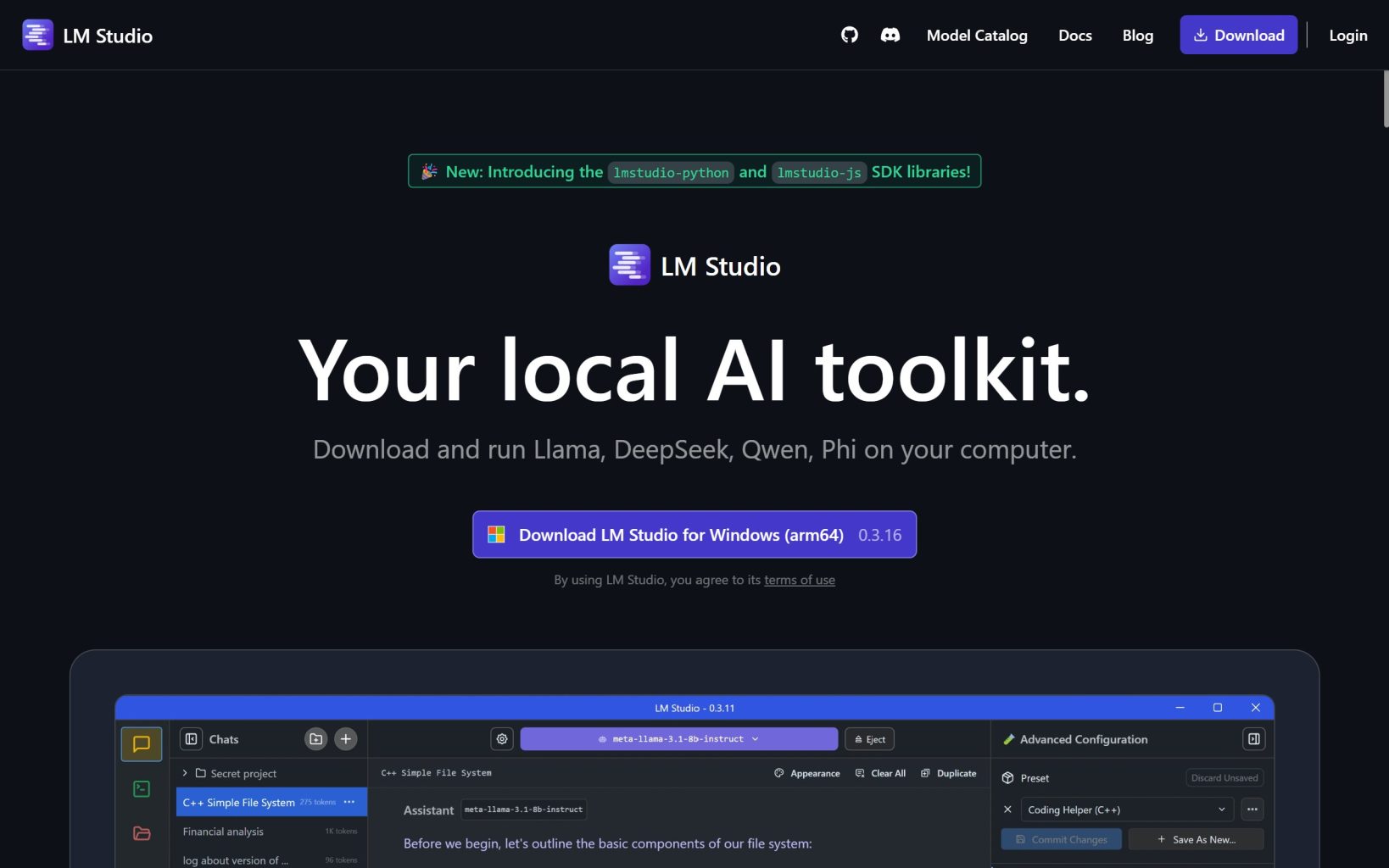

LM Studio là một ứng dụng dành cho máy tính để bàn (desktop), tương thích với các hệ điều hành Windows, macOS và Linux, được thiết kế để giúp người dùng khám phá, tải xuống và chạy các mô hình ngôn ngữ lớn (LLM) cục bộ một cách cực kỳ dễ dàng.5 Với giao diện đồ họa trực quan, LM Studio đặc biệt thân thiện với người mới bắt đầu, giúp loại bỏ những rào cản kỹ thuật phức tạp thường gặp khi làm việc với LLM.5 Trang chủ chính thức của LM Studio (https://lmstudio.ai/) nêu bật các tính năng giúp người dùng dễ dàng tải, chạy và tương tác với LLM ngay trên máy tính cá nhân.8

Tại sao nên chọn LM Studio?

Có nhiều lý do khiến LM Studio trở thành lựa chọn hàng đầu cho việc trải nghiệm LLM cục bộ:

- Miễn phí cho mục đích sử dụng cá nhân.7

- Dễ sử dụng: Người dùng không cần phải có kiến thức chuyên sâu về giao diện dòng lệnh (command-line) hay các cấu hình phức tạp.5

- Quản lý model tiện lợi: LM Studio tích hợp sẵn một trình duyệt model, cho phép tìm kiếm, tải xuống các model từ Hugging Face và quản lý chúng ngay trong ứng dụng.7

- Giao diện chat trực quan: Cho phép người dùng tương tác trực tiếp với model đã tải để thử nghiệm các câu lệnh (prompt) một cách nhanh chóng.5

- Local API Server: Chỉ với một cú nhấp chuột, người dùng có thể tạo ra một server API cục bộ tương thích với chuẩn OpenAI, giúp dễ dàng tích hợp LLM vào các ứng dụng hoặc quy trình làm việc khác.5

- Hỗ trợ đa dạng model: LM Studio có khả năng chạy các model ở định dạng GGUF (thông qua thư viện llama.cpp nền tảng) và định dạng MLX (đặc biệt tối ưu cho máy Mac).7

Yêu cầu hệ thống để sử dụng DeepSeek R1 0528 Qwen 8B với LM Studio:

Để có thể chạy DeepSeek R1 0528 Qwen 8B một cách hiệu quả trên LM Studio, máy tính của bạn cần đáp ứng một số yêu cầu nhất định:

- Hệ điều hành: Windows (phiên bản x86 hoặc ARM), macOS (sử dụng chip M series), hoặc Linux (phiên bản x86 có hỗ trợ tập lệnh AVX2).7

- RAM: Một điểm cần làm rõ và hết sức lưu ý!

- Mặc dù có thông tin ban đầu đề cập đến khả năng chạy trên “4GB RAM”, điều này cần được xem xét cẩn trọng. Chỉ riêng file model DeepSeek 8B đã được lượng tử hóa ở mức Q4_0 (một mức nén khá tốt) đã có dung lượng khoảng 4.79GB.19

- Bên cạnh đó, bản thân ứng dụng LM Studio và hệ điều hành cũng tiêu tốn một phần RAM đáng kể.

- Các tài liệu hướng dẫn sử dụng LM Studio thường khuyến nghị tối thiểu 8GB RAM trở lên, và có GPU rời là một lợi thế.20 Cụ thể hơn, đối với một model 8 tỷ tham số như LLaMA 3 8B (có kích thước file tương đương DeepSeek 8B Q4_0 là 4.7GB), khuyến nghị là 16GB RAM.20 Một thảo luận trên diễn đàn Hugging Face cũng chỉ ra rằng ngay cả 4GB VRAM (bộ nhớ đồ họa) cũng “hơi thiếu” để chạy mượt một model 7 tỷ tham số.21

- Khuyến nghị thực tế: Để chạy DeepSeek R1 0528 Qwen 8B (kể cả phiên bản Q4_0), người dùng nên trang bị máy tính có ít nhất 8GB RAM hệ thống. Tuy nhiên, để có trải nghiệm mượt mà và ổn định hơn, 16GB RAM sẽ là lựa chọn lý tưởng, đặc biệt nếu máy tính không có card đồ họa rời hoặc VRAM hạn chế. Với 4GB RAM, khả năng cao là mô hình sẽ không thể chạy được, hoặc nếu chạy được thì tốc độ sẽ rất chậm và trải nghiệm người dùng sẽ không tốt.

- VRAM (Nếu có card đồ họa rời): LM Studio khuyến nghị ít nhất 6GB VRAM cho card NVIDIA hoặc AMD.7 Nếu máy tính của bạn có VRAM đủ lớn (ví dụ 8GB trở lên), model có thể được tăng tốc đáng kể bằng cách offload một phần xử lý sang GPU.

- Dung lượng lưu trữ: Cần khoảng 10-20GB dung lượng ổ cứng trống, tùy thuộc vào số lượng model bạn dự định tải về.20

Khi xem xét khả năng chạy các mô hình AI mạnh mẽ trên phần cứng cá nhân, người dùng thường bị thu hút bởi những tuyên bố về yêu cầu cấu hình thấp, chẳng hạn như “chạy trên laptop với 4GB RAM”. Tuy nhiên, dữ liệu kỹ thuật, bao gồm kích thước thực tế của file model và các khuyến nghị từ nhiều nguồn uy tín, cho thấy điều này là rất khó khả thi đối với một mô hình 8 tỷ tham số, ngay cả khi đã được lượng tử hóa.19 Có một khoảng cách nhất định giữa mong muốn về khả năng tiếp cận rộng rãi (chạy trên phần cứng yếu) và thực tế về yêu cầu tài nguyên của các mô hình AI tiên tiến. Mặc dù các công cụ như LM Studio và các kỹ thuật lượng tử hóa giúp LLM trở nên dễ tiếp cận hơn, người dùng vẫn cần hiểu rằng “mạnh mẽ” và “nhẹ” thường là hai yếu tố khó dung hòa. Việc quảng bá khả năng chạy trên cấu hình quá thấp có thể gây ra những hiểu lầm và thất vọng không đáng có. Do đó, sự minh bạch về yêu cầu hệ thống thực tế là vô cùng quan trọng. Thay vì tập trung vào một con số tối thiểu khó đạt được, cần nhấn mạnh rằng ngay cả với 8GB hay 16GB RAM, việc có thể chạy một LLM 8 tỷ tham số cục bộ đã là một bước tiến vượt bậc so với trước đây.

Mặt khác, LM Studio đang dần khẳng định vị thế không chỉ là một trình chạy model đơn thuần mà còn là một “bộ kit AI” toàn diện cho người dùng cuối. Ứng dụng này không chỉ cho phép chạy model mà còn cung cấp các tính năng như khám phá model, giao diện chat tương tác, máy chủ API cục bộ, và có kế hoạch hỗ trợ cả RAG (Retrieval Augmented Generation – Sinh tăng cường truy xuất) để trò chuyện với tài liệu cá nhân.5 LM Studio đang định vị mình là một “AI toolkit” 8, giúp người dùng không chỉ “chạy” AI mà còn “sử dụng” và “tích hợp” AI vào công việc hoặc các ứng dụng khác một cách dễ dàng. Điều này làm giảm đáng kể rào cản kỹ thuật và thúc đẩy việc ứng dụng LLM cục bộ một cách rộng rãi hơn. Sự phát triển của các công cụ như LM Studio cho thấy một tương lai nơi người dùng không chuyên cũng có thể khai thác sức mạnh của LLM cho các mục đích cá nhân hoặc doanh nghiệp nhỏ mà không cần phụ thuộc vào các dịch vụ đám mây đắt đỏ hoặc đội ngũ kỹ thuật chuyên biệt.

Hướng Dẫn Cài Đặt DeepSeek R1 0528 Qwen 8B với LM Studio (Từng Bước Một)

Sau đây là các bước chi tiết để bạn có thể tự tay cài đặt và trải nghiệm mô hình DeepSeek R1 0528 Qwen 8B ngay trên máy tính của mình bằng công cụ LM Studio.

- Bước 1: Tải và Cài Đặt LM Studio – Ngôi Nhà Cho AI Của Bạn

- Đầu tiên, hãy truy cập trang web chính thức của LM Studio tại địa chỉ: https://lmstudio.ai/.8

- Tại đây, bạn sẽ tìm thấy các phiên bản LM Studio dành cho các hệ điều hành phổ biến như Windows, macOS và Linux. Hãy chọn và tải về phiên bản phù hợp với máy tính của bạn. Kích thước file cài đặt thường dao động quanh mức 400MB.7

- Sau khi tải về, bạn tiến hành cài đặt LM Studio. Đối với macOS, bạn chỉ cần mở file DMG và kéo biểu tượng LM Studio vào thư mục Applications. Đối với Windows, bạn chạy file.exe và làm theo các hướng dẫn trên màn hình.7 Quá trình cài đặt khá đơn giản và nhanh chóng.

- Bước 2: Tìm và Tải Model “deepseek r1 0528 qwen 8b” – Chọn Đúng “Vũ Khí”

- Sau khi cài đặt xong, hãy mở ứng dụng LM Studio. Giao diện chính sẽ hiện ra, bạn tìm đến tab tìm kiếm (thường có biểu tượng kính lúp ở thanh công cụ bên trái).

- Trong ô tìm kiếm, gõ chính xác từ khóa: “deepseek r1 0528 qwen 8b”.

- Giải thích về Quantization (Lượng tử hóa): Sức mạnh tối ưu cho máy yếu.

- Trước khi chọn model, bạn cần hiểu một chút về “Quantization”. Đây là một kỹ thuật quan trọng trong việc tối ưu LLM, giúp giảm độ chính xác của các trọng số trong mô hình (ví dụ, từ dạng số thực dấu phẩy động 16-bit (FP16) xuống dạng số nguyên 8-bit (INT8) hoặc thậm chí 4-bit (INT4)). Mục đích chính là làm giảm đáng kể kích thước file của mô hình và yêu cầu về bộ nhớ (RAM/VRAM), đồng thời giúp mô hình chạy nhanh hơn trên các phần cứng có tài nguyên hạn chế.22

- Lợi ích chính của quantization: Mô hình sẽ có kích thước nhỏ hơn, tốc độ xử lý nhanh hơn và tiêu thụ ít RAM/VRAM hơn, đổi lại có thể có một chút suy giảm không đáng kể về độ chính xác của mô hình.22

- Định dạng GGUF: Đây là một định dạng file rất phổ biến hiện nay dành cho các mô hình LLM đã được lượng tử hóa. Các file GGUF thường được sử dụng với thư viện llama.cpp, một công cụ nền tảng mà LM Studio tận dụng để chạy các mô hình cục bộ.7

- Chọn phiên bản model: Ưu tiên “bartowski version” với quantization “Q4_0”

- Trong danh sách kết quả tìm kiếm các file model GGUF, hãy tìm kiếm các phiên bản được cung cấp bởi người dùng có tên “bartowski”.13 Đây là một thành viên cộng đồng rất tích cực và uy tín, thường xuyên chia sẻ các phiên bản GGUF chất lượng cao của nhiều LLM phổ biến. Các mô hình từ “bartowski” cho deepseek-ai/DeepSeek-R1-0528-Qwen3-8B đã được xác nhận là có sẵn.13

- Cụ thể, bạn hãy tìm file có tên chứa cụm Q4_0. Ví dụ, tên file có thể là DeepSeek-R1-0528-Qwen3-8B-Q4_0.gguf.

- Kích thước file: Phiên bản này thường có kích thước khoảng 4.79GB.19

- Lưu ý quan trọng về 4GB RAM: Như đã được nhấn mạnh ở Mục III, chỉ riêng file model này đã lớn hơn 4GB. Do đó, để có thể chạy được mô hình này một cách ổn định, máy tính của bạn cần có tổng dung lượng RAM hệ thống nhiều hơn đáng kể (khuyến nghị tối thiểu là 8GB, và lý tưởng là 16GB).

- Ưu điểm của Q4_0 (theo ghi chú của bartowski): Mặc dù là một định dạng “legacy” (cũ hơn một chút so với các định dạng K-quants mới), Q4_0 có một ưu điểm là hỗ trợ tính năng “online repacking”. Tính năng này giúp tối ưu hóa cách model được tải vào bộ nhớ để cải thiện hiệu suất xử lý trên các CPU kiến trúc ARM (như chip M series của Apple) và các CPU có hỗ trợ tập lệnh AVX.19

- Các lựa chọn Quantization phổ biến khác từ Bartowski cho DeepSeek R1 0528 Qwen 8B:

- Để giúp người dùng có thêm lựa chọn phù hợp với cấu hình máy và nhu cầu sử dụng, dưới đây là bảng so sánh một số phiên bản quantization GGUF phổ biến của DeepSeek R1 0528 Qwen 8B do Bartowski cung cấp. Bảng này sẽ cung cấp thông tin rõ ràng về kích thước file, mô tả và khuyến nghị sử dụng, giúp bạn đưa ra quyết định tốt nhất.

Bảng 1: So sánh các phiên bản Quantization GGUF của DeepSeek R1 0528 Qwen 8B (từ Bartowski)

| Tên Quant (File từ Bartowski) | Loại Quant | Kích thước File | Mô tả/Khuyến nghị (từ Bartowski) | Lưu ý RAM (Ước tính) |

| …Qwen3-8B-Q4_0.gguf | Q4_0 | 4.79GB | Legacy, online repacking cho ARM/AVX CPU. | >8GB, lý tưởng 16GB+ |

| …Qwen3-8B-Q4_K_M.gguf | Q4_K_M | 5.03GB | Chất lượng tốt, kích thước mặc định cho hầu hết trường hợp, khuyến nghị. | >8GB, lý tưởng 16GB+ |

| …Qwen3-8B-Q4_K_S.gguf | Q4_K_S | 4.80GB | Chất lượng thấp hơn chút, tiết kiệm dung lượng hơn, khuyến nghị. | >8GB, lý tưởng 16GB+ |

| …Qwen3-8B-IQ4_XS.gguf | IQ4_XS | 4.56GB | Chất lượng khá, nhỏ hơn Q4_K_S, hiệu năng tương đương, khuyến nghị. | >8GB, lý tưởng 16GB+ |

| …Qwen3-8B-Q3_K_M.gguf | Q3_K_M | 4.12GB | Chất lượng thấp. | >8GB, có thể chạy trên 8GB |

| …Qwen3-8B-Q5_K_M.gguf | Q5_K_M | 5.85GB | Chất lượng cao, khuyến nghị. | >10GB, lý tưởng 16GB-20GB+ |

*(Nguồn dữ liệu: [19])*

* **Lưu ý cho người dùng macOS (Chip M series): Cân nhắc Model MLX**

* Một ưu điểm của LM Studio trên máy Mac là nó hỗ trợ các model ở định dạng MLX, một framework được Apple phát triển đặc biệt cho machine learning trên chip Apple Silicon.[8]

* MLX được tối ưu hóa cho kiến trúc bộ nhớ hợp nhất (unified memory) của Apple, giúp tăng cường hiệu suất xử lý.[26, 27, 28]

* Nếu bạn đang sử dụng máy Mac với chip M series, khi tìm kiếm model trong LM Studio, bạn có thể thử tìm các phiên bản MLX của DeepSeek 8B (nếu có sẵn). Chúng có tiềm năng mang lại hiệu suất tốt hơn so với các file GGUF trên nền tảng Mac. Tuy nhiên, do yêu cầu ban đầu là tìm phiên bản GGUF từ “bartowski”, phần này chỉ mang tính chất gợi ý thêm để bạn có thêm lựa chọn tối ưu.

* Sau khi đã chọn được file model ưng ý (ví dụ: `DeepSeek-R1-0528-Qwen3-8B-Q4_0.gguf`), bạn chỉ cần nhấn nút “Download” bên cạnh tên file đó. Hãy kiên nhẫn chờ đợi quá trình tải về hoàn tất, thời gian tải sẽ phụ thuộc vào tốc độ mạng của bạn và kích thước của file model.

- Bước 3: Tải Model Vào LM Studio và Bắt Đầu “Trò Chuyện” Cùng AI

- Khi model đã được tải về thành công, bạn chuyển sang tab “Chat” trong LM Studio (thường có biểu tượng bong bóng chat ở cột công cụ bên trái).7

- Ở phía trên cùng của giao diện chat, bạn sẽ thấy một danh sách thả xuống. Hãy nhấp vào đó và chọn model DeepSeek R1 0528 Qwen 8B mà bạn vừa tải về.

- Tiếp theo, nhấn nút “Load model” (hoặc một nút tương tự có chức năng tải model). LM Studio sẽ bắt đầu quá trình nạp model vào bộ nhớ của máy tính. Thời gian nạp có thể mất vài giây đến vài phút, tùy thuộc vào tốc độ xử lý của máy và kích thước của model.

- Khi model đã được nạp xong và sẵn sàng hoạt động (thường sẽ có thông báo hoặc trạng thái thay đổi trên giao diện), bạn có thể bắt đầu nhập câu hỏi, yêu cầu hoặc bất kỳ đoạn văn bản nào vào ô chat ở phía dưới màn hình. Sau đó, nhấn phím Enter hoặc nút gửi để AI xử lý và đưa ra phản hồi.

- Bước 4: Tinh Chỉnh AI Với System Prompt – “Luật Chơi” Cho Cuộc Hội Thoại Thông Minh Hơn

- Tại sao cần System Prompt? System Prompt (lời nhắc hệ thống) là một công cụ rất hữu ích để định hướng cách AI trả lời. Bằng cách cung cấp một chỉ dẫn ban đầu cho AI, bạn có thể giúp nó tránh trả lời lan man, “suy nghĩ quá nhiều” (overthinking) một cách không cần thiết, hoặc đưa ra những thông tin không phù hợp với mong muốn của bạn.29

- Cách thêm System Prompt trong LM Studio:

- Trong giao diện Chat của LM Studio, bạn hãy tìm đến mục có tên là “System Prompt”. Vị trí của mục này có thể khác nhau tùy theo phiên bản LM Studio, nhưng thường nó sẽ nằm ở cột bên phải của cửa sổ chat, hoặc trong phần cài đặt (settings) của cuộc trò chuyện hiện tại.

- Nhập chỉ dẫn của bạn vào ô System Prompt.

- Ví dụ System Prompt hữu ích:

- “Bạn là một trợ lý AI hữu ích. Hãy trả lời ngắn gọn và đi thẳng vào vấn đề.” 30

- “Chỉ tập trung vào câu hỏi được đưa ra. Không cung cấp thông tin không liên quan.” 30

- “Hãy đóng vai một lập trình viên Python chuyên nghiệp và đưa ra các giải pháp code hiệu quả.” 30

- “Vui lòng trả lời bằng tiếng Việt.”

- “Hãy tóm tắt nội dung sau thành 3 gạch đầu dòng chính.”

- Việc sử dụng System Prompt giúp bạn kiểm soát tốt hơn kết quả đầu ra của AI, làm cho cuộc hội thoại trở nên thông minh và hiệu quả hơn.30

Việc người dùng được hướng dẫn tìm các mô hình từ những cá nhân như “bartowski” 13 hoặc “TheBloke” 32 cho thấy vai trò quan trọng của cộng đồng trong việc cung cấp các mô hình AI dễ tiếp cận. Những người đóng góp này dành thời gian và công sức để lượng tử hóa và chia sẻ các LLM dưới định dạng GGUF, giúp người dùng cuối dễ dàng tải về và sử dụng hơn rất nhiều. Nếu không có họ, việc tiếp cận các mô hình nguồn mở sẽ trở nên phức tạp hơn, đòi hỏi người dùng phải tự thực hiện quá trình lượng tử hóa. Cộng đồng, bao gồm các cá nhân và các nhóm như Unsloth 34, đang đóng một vai trò then chốt trong việc “dân chủ hóa” LLM. Họ là cầu nối quan trọng giữa các nhà nghiên cứu, các tổ chức phát hành mô hình gốc và người dùng cuối. Sự phát triển của LLM nguồn mở phụ thuộc rất nhiều vào những nỗ lực không mệt mỏi này.

Một chi tiết kỹ thuật thú vị liên quan đến phiên bản Q4_0 từ Bartowski là nó “hỗ trợ online repacking cho việc suy luận trên CPU ARM và AVX”.19 Đây là một tính năng của thư viện llama.cpp (nền tảng của LM Studio) có thể tự động tối ưu hóa cách mô hình được tải vào bộ nhớ, từ đó tăng tốc độ xử lý trên một số kiến trúc CPU nhất định. Người dùng có thể không trực tiếp nhận thấy sự tối ưu hóa này đang diễn ra, nhưng nó có thể đóng góp vào một trải nghiệm mượt mà hơn, đặc biệt trên các máy Mac M series (sử dụng kiến trúc ARM) hoặc các PC có CPU hỗ trợ tập lệnh AVX2. Đây là một ví dụ điển hình về cách các cải tiến ở tầng kỹ thuật thấp hơn (như trong llama.cpp) mang lại lợi ích thiết thực cho người dùng cuối thông qua các ứng dụng thân thiện như LM Studio, mà không đòi hỏi người dùng phải can thiệp hay cấu hình phức tạp.

Khai Thác Tối Đa DeepSeek R1 0528 Qwen 8B Cục Bộ – AI Phục Vụ Bạn

Khi đã cài đặt thành công DeepSeek R1 0528 Qwen 8B trên LM Studio, bạn đã sở hữu một công cụ AI mạnh mẽ ngay trên máy tính của mình. Dưới đây là một số gợi ý về các ứng dụng thực tế và mẹo sử dụng để bạn có thể khai thác tối đa tiềm năng của nó:

- Gợi ý một số ứng dụng thực tế cho model 8B chạy local:

- Hỗ trợ viết lách đa dạng: Từ việc soạn thảo email chuyên nghiệp, viết các bài blog hấp dẫn, tóm tắt những văn bản dài dòng, cho đến việc lên ý tưởng và sáng tạo nội dung mới. Khả năng này đặc biệt hữu ích cho những người làm nội dung, marketing hoặc đơn giản là muốn cải thiện kỹ năng viết của mình.1

- Trợ thủ đắc lực cho lập trình viên: DeepSeek R1 0528 Qwen 8B có thể giúp giải thích các đoạn code phức tạp, hỗ trợ tìm và gỡ lỗi (debug), viết các đoạn code nhỏ theo yêu cầu, hoặc thậm chí là một công cụ hữu ích để học một ngôn ngữ lập trình mới. Nhiều người dùng đã xác nhận khả năng viết code chính xác của mô hình này.2

- Công cụ học tập và nghiên cứu hiệu quả: Bạn có thể sử dụng AI để tìm hiểu các khái niệm mới một cách nhanh chóng, đặt câu hỏi để làm rõ những vấn đề chưa hiểu, hoặc nhờ AI hỗ trợ chuẩn bị tài liệu cho các bài thuyết trình hay báo cáo.1

- Phân tích dữ liệu văn bản đơn giản: Mô hình có khả năng xử lý và tóm tắt thông tin từ các nguồn văn bản, giúp bạn nắm bắt ý chính một cách nhanh chóng.

- Xây dựng chatbot cá nhân: Tạo ra một trợ lý ảo riêng tư, hoạt động hoàn toàn offline, có thể trò chuyện, giải đáp thắc mắc hoặc thực hiện các tác vụ đơn giản theo yêu cầu của bạn.

- Các lĩnh vực như nghiên cứu khoa học, phát triển phần mềm (tạo code, tự động hóa kiểm thử), các ứng dụng đòi hỏi tính bảo mật cao (như trong y tế hoặc tài chính) và giáo dục đều có thể hưởng lợi từ việc sử dụng LLM cục bộ.1 Một người dùng còn chia sẻ rằng DeepSeek 8B Qwen3 có thể tạo ra các biểu đồ PlantUML một cách chính xác.38

- Mẹo sử dụng LM Studio và DeepSeek 8B hiệu quả:

- Thử nghiệm với các System Prompt khác nhau: Đừng ngần ngại thay đổi các lời nhắc hệ thống để tìm ra phong cách trả lời hoặc vai trò của AI phù hợp nhất với nhu cầu của bạn.

- Điều chỉnh các tham số trong LM Studio (nếu cần thiết):

- Context Length (Độ dài ngữ cảnh): Tham số này xác định lượng thông tin từ cuộc trò chuyện trước đó mà model có thể “ghi nhớ” để duy trì tính liên tục. Tăng giá trị này có thể giúp AI hiểu ngữ cảnh tốt hơn trong các cuộc hội thoại dài, nhưng cũng sẽ tiêu tốn nhiều RAM hơn.20

- Temperature (Nhiệt độ): Tham số này kiểm soát mức độ sáng tạo hoặc ngẫu nhiên trong các câu trả lời của AI. Giá trị thấp hơn (ví dụ 0.2 – 0.5) sẽ cho ra các câu trả lời tập trung, dễ đoán hơn, trong khi giá trị cao hơn (ví dụ 0.7 – 1.0) sẽ khuyến khích AI tạo ra các phản hồi đa dạng và sáng tạo hơn, nhưng đôi khi có thể kém chính xác.20

- GPU Layers (Số lớp GPU offload): Nếu máy tính của bạn có card đồ họa rời (GPU) với VRAM đủ lớn, bạn có thể thử nghiệm offload (chuyển một phần) các lớp của mô hình lên GPU để tăng tốc độ xử lý. Hãy thử nghiệm với các giá trị khác nhau để tìm ra thiết lập tối ưu cho phần cứng của bạn.20

- Chia nhỏ các tác vụ phức tạp: Thay vì đưa ra một yêu cầu lớn và phức tạp trong một prompt duy nhất, hãy thử chia nhỏ nó thành nhiều bước hoặc nhiều prompt nhỏ hơn, đơn giản hơn. Điều này giúp AI dễ dàng xử lý và thường cho ra kết quả tốt hơn.30

- Kiên nhẫn là chìa khóa: Nên nhớ rằng các mô hình chạy cục bộ, đặc biệt là trên các máy tính có cấu hình không quá cao, có thể sẽ hoạt động chậm hơn so với các dịch vụ AI trên đám mây. Hãy kiên nhẫn và cho AI đủ thời gian để xử lý yêu cầu của bạn.

Khi sử dụng một mô hình 8 tỷ tham số chạy cục bộ, điều quan trọng là phải cân bằng giữa khả năng và giới hạn của nó. Một mô hình 8B như DeepSeek R1 0528 Qwen 8B là khá mạnh mẽ và có thể thực hiện nhiều tác vụ hữu ích một cách ấn tượng.1 Tuy nhiên, nó vẫn là một mô hình 8 tỷ tham số và không thể so sánh trực tiếp về mọi mặt với các mô hình khổng lồ hàng trăm tỷ tham số được vận hành trên các cụm máy chủ đám mây mạnh mẽ. Người dùng cần có những kỳ vọng thực tế. Mô hình 8B chạy cục bộ là một công cụ tuyệt vời cho các tác vụ cá nhân, thử nghiệm, học hỏi và các ứng dụng không yêu cầu độ phức tạp cực cao hoặc kiến thức cập nhật đến từng giây (trừ khi mô hình được tinh chỉnh thường xuyên với dữ liệu mới). Sức mạnh thực sự của mô hình 8B local nằm ở sự tiện lợi, miễn phí, tính riêng tư cao và khả năng tùy biến linh hoạt. Nó không nhằm mục đích thay thế hoàn toàn các dịch vụ AI trên đám mây cho mọi trường hợp, mà là một công cụ bổ sung mạnh mẽ và linh hoạt trong bộ công cụ AI của bạn.

Việc AI mạnh mẽ giờ đây nằm trong tay người dùng cá nhân mở ra tiềm năng sáng tạo không giới hạn. Khi các rào cản về chi phí API hay giới hạn sử dụng được gỡ bỏ, người dùng có toàn quyền kiểm soát, tự do khám phá các ý tưởng mới, tinh chỉnh mô hình cho các nhu cầu rất cụ thể, hoặc tích hợp AI vào các dự án cá nhân theo những cách độc đáo mà trước đây họ không thể thực hiện. Điều này có thể châm ngòi cho một làn sóng đổi mới từ dưới lên (“grassroots innovation”), nơi các cá nhân và nhóm nhỏ tạo ra các ứng dụng AI chuyên biệt, phục vụ những nhu cầu ngách mà các công ty lớn có thể không chú trọng hoặc không ưu tiên phát triển. Trao quyền truy cập AI mạnh mẽ cho người dùng cá nhân không chỉ là về việc sử dụng các công cụ hiện có, mà còn là về việc tạo ra các công cụ và giải pháp mới, làm phong phú thêm hệ sinh thái AI và thúc đẩy những ứng dụng AI thực sự mang tính cá nhân hóa.

Tương Lai AI Trong Tầm Tay Bạn – Hãy Bắt Đầu Khám Phá!

Sự kết hợp giữa mô hình ngôn ngữ lớn mạnh mẽ như DeepSeek R1 0528 Qwen 8B và công cụ thân thiện với người dùng như LM Studio thực sự mang đến một cơ hội tuyệt vời cho bất kỳ ai muốn khám phá và ứng dụng trí tuệ nhân tạo. Giờ đây, việc trải nghiệm AI đỉnh cao, hoàn toàn miễn phí, đảm bảo riêng tư và hoạt động ngay trên chiếc máy tính cá nhân của bạn không còn là điều xa vời.

Nhìn về tương lai, sự phát triển không ngừng của các mô hình LLM nguồn mở và các công cụ hỗ trợ như LM Studio hứa hẹn một kỷ nguyên AI ngày càng dễ tiếp cận, mạnh mẽ và phục vụ tốt hơn cho tất cả mọi người. Việc trang bị cho người dùng không chỉ công cụ mà còn cả kiến thức để hiểu và tự tin sử dụng công nghệ AI là yếu tố then chốt. Khi người dùng hiểu rõ hơn, họ sẽ có khả năng khai thác tiềm năng của AI một cách hiệu quả hơn và thậm chí là đóng góp ngược lại cho sự phát triển của cộng đồng. Tương lai của AI thực sự đang nằm trong tầm tay bạn – hãy bắt đầu hành trình khám phá ngay hôm nay!

Nguồn tham khảo

- Comparing the Best LLMs of 2025: GPT, DeepSeek, Claude & More – Which AI Model Wins? – Web Design Sussex by Sokada, accessed May 30, 2025, https://www.sokada.co.uk/blog/comparing-the-best-llms-of-2025/

- deepseek-r1:8b-0528-qwen3-fp16 – Ollama, accessed May 30, 2025, https://ollama.com/library/deepseek-r1:8b-0528-qwen3-fp16

- New Deepseek R1-0528 Update is INSANE – Analytics Vidhya, accessed May 30, 2025, https://www.analyticsvidhya.com/blog/2025/05/deepseek-r1-0528/

- Triangle104/DeepSeek-R1-0528-Qwen3-8B … – Hugging Face, accessed May 30, 2025, https://huggingface.co/Triangle104/DeepSeek-R1-0528-Qwen3-8B-Q4_K_S-GGUF

- LM Studio: Công cụ chạy LLM Local Nhanh chóng Dễ dàng cho …, accessed May 30, 2025, https://200lab.io/blog/lm-studio-la-gi

- What is LM Studio Used For? – BytePlus, accessed May 30, 2025, https://www.byteplus.com/en/topic/417431

- LM Studio Là Gì? Hướng Dẫn Cài Đặt và Sử Dụng Mô Hình Ngôn …, accessed May 30, 2025, https://thuegpu.vn/lm-studio-la-gi-huong-dan-cai-dat-va-su-dung-llm/

- LM Studio – Discover, download, and run local LLMs, accessed May 30, 2025, https://lmstudio.ai/

- LM Studio vs Ollama: Which Local LLM Platform to choose – PromptLayer, accessed May 30, 2025, https://blog.promptlayer.com/lm-studio-vs-ollama-choosing-the-right-local-llm-platform/

- Cách Tải Xuống và Sử Dụng Ollama Để Chạy LLM Trên Máy Tính Cá Nhân – Apidog, accessed May 30, 2025, https://apidog.com/vi/blog/how-to-download-and-use-ollama/

- Best DeepSeek alternatives for running reasoning LLMs locally in 2025 – BytePlus, accessed May 30, 2025, https://www.byteplus.com/en/topic/384864

- Deepseek R1 0528 Qwen3 8B (free) – API, Providers, Stats – OpenRouter, accessed May 30, 2025, https://openrouter.ai/deepseek/deepseek-r1-0528-qwen3-8b:free

- DeepSeek-R1-0528 Official Benchmarks Released!!! : r/LocalLLaMA – Reddit, accessed May 30, 2025, https://www.reddit.com/r/LocalLLaMA/comments/1ky8vlm/deepseekr10528_official_benchmarks_released/

- A Step-by-Step Guide to Install DeepSeek-R1-0528 Locally with Ollama, vLLM or Transformers – DEV Community, accessed May 30, 2025, https://dev.to/nodeshiftcloud/a-step-by-step-guide-to-install-deepseek-r1-0528-locally-with-ollama-vllm-or-transformers-k29

- Qwen – Wikipedia, accessed May 30, 2025, https://en.wikipedia.org/wiki/Qwen

- Qwen LLMs – – Alibaba Cloud Documentation Center, accessed May 30, 2025, https://www.alibabacloud.com/help/en/model-studio/what-is-qwen-llm

- [2025] Qwen – Alibaba Cloud Large Language Model – VinaHost, accessed May 30, 2025, https://vinahost.vn/alibaba-cloud-large-language-model/

- Qwen AI là gì? Cách tạo tài khoản và hướng dẫn sử dụng Qwen AI – XTmobile, accessed May 30, 2025, https://www.xtmobile.vn/qwen-ai-la-gi

- bartowski/deepseek-ai_DeepSeek-R1-0528-Qwen3-8B-GGUF …, accessed May 30, 2025, https://huggingface.co/bartowski/deepseek-ai_DeepSeek-R1-0528-Qwen3-8B-GGUF

- LM Studio Guide – LJAweb – Local AI, Global Ideas, accessed May 30, 2025, https://ljaweb.com/guides/lm-studio/

- Best LLMs that can run on 4gb VRAM – Beginners – Hugging Face Forums, accessed May 30, 2025, https://discuss.huggingface.co/t/best-llms-that-can-run-on-4gb-vram/136843

- What is Quantization? | IBM, accessed May 30, 2025, https://www.ibm.com/think/topics/quantization

- Quantization | How-to guides – Llama, accessed May 30, 2025, https://www.llama.com/docs/how-to-guides/quantization/

- bartowski/facebook_KernelLLM-GGUF · Hugging Face, accessed May 30, 2025, https://huggingface.co/bartowski/facebook_KernelLLM-GGUF

- bartowski/TAID-LLM-1.5B-GGUF – Hugging Face, accessed May 30, 2025, https://huggingface.co/bartowski/TAID-LLM-1.5B-GGUF

- opensource.apple.com, accessed May 30, 2025, https://opensource.apple.com/projects/mlx#:~:text=MLX%20is%20an%20array%20framework,familiar%20to%20use%20and%20flexible.

- MLX – Apple Open Source, accessed May 30, 2025, https://opensource.apple.com/projects/mlx

- Getting started with Apple MLX | ML_NEWS3 – Weights & Biases – Wandb, accessed May 30, 2025, https://wandb.ai/byyoung3/ML_NEWS3/reports/Getting-started-with-Apple-MLX–Vmlldzo5Njk5MTk1

- OverThink: Slowdown Attacks on Reasoning LLMs – arXiv, accessed May 30, 2025, https://arxiv.org/html/2502.02542v1

- Stop overthinking your AI prompts – Data School, accessed May 30, 2025, https://www.dataschool.io/simple-ai-prompting-tips/

- ask-a-question/core_backend/app/llm_call/llm_prompts.py at main – GitHub, accessed May 30, 2025, https://github.com/IDinsight/ask-a-question/blob/main/core_backend/app/llm_call/llm_prompts.py

- Tom Jobbins TheBloke – GitHub, accessed May 30, 2025, https://github.com/thebloke

- TheBloke (Tom Jobbins) – Hugging Face, accessed May 30, 2025, https://huggingface.co/TheBloke

- Unsloth AI – Hugging Face, accessed May 30, 2025, https://huggingface.co/unsloth

- Models – Hugging Face, accessed May 30, 2025, https://huggingface.co/models?library=gguf

- unsloth/DeepSeek-R1-0528-Qwen3-8B-GGUF · Hugging Face, accessed May 30, 2025, https://huggingface.co/unsloth/DeepSeek-R1-0528-Qwen3-8B-GGUF

- DeepSeek vs. Qwen: A Detailed Analysis With Versions – REVE Chat, accessed May 30, 2025, https://www.revechat.com/blog/deepseek-vs-qwen/

- No offense: Deepseek 8b 0528 Qwen3 Not Better Than Qwen3 8B : r/LocalLLaMA – Reddit, accessed May 30, 2025, https://www.reddit.com/r/LocalLLaMA/comments/1kycymx/no_offense_deepseek_8b_0528_qwen3_not_better_than/

Bình luận